Еще лет пять назад вопрос копирайтинга вызывал у SEO-специалистов головную боль. Десятки технических заданий. Дефицит вменяемых авторов (читай единицы). Бесконечные правки тысяч строк малокачественного текста. Едва ли не одна из самых трудозатратных зон в digital-проектах.

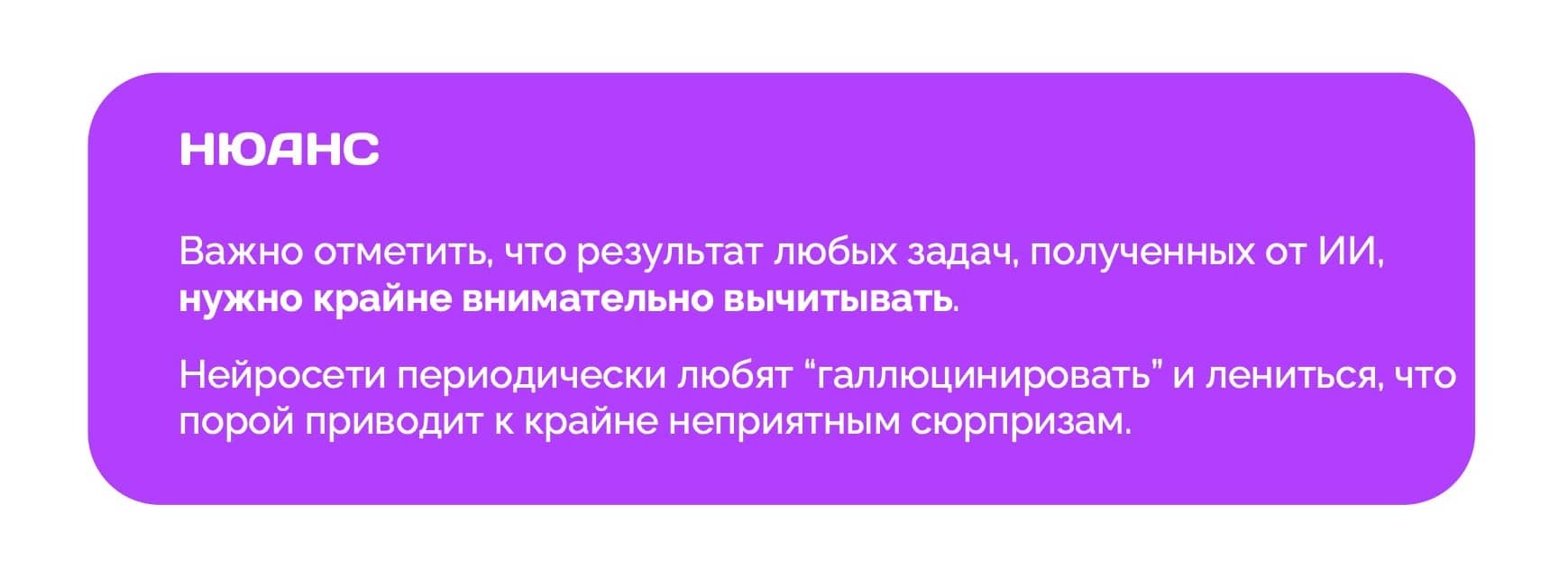

С появлением нейросетей ситуация кардинально поменялась. Современные ИИ-инструменты не просто ускоряют работу SEO-специалистов. Речь уже не про то, чтобы «писать быстрее» или «дешевле». Нейросети принципиально поменяли логику создания контента.

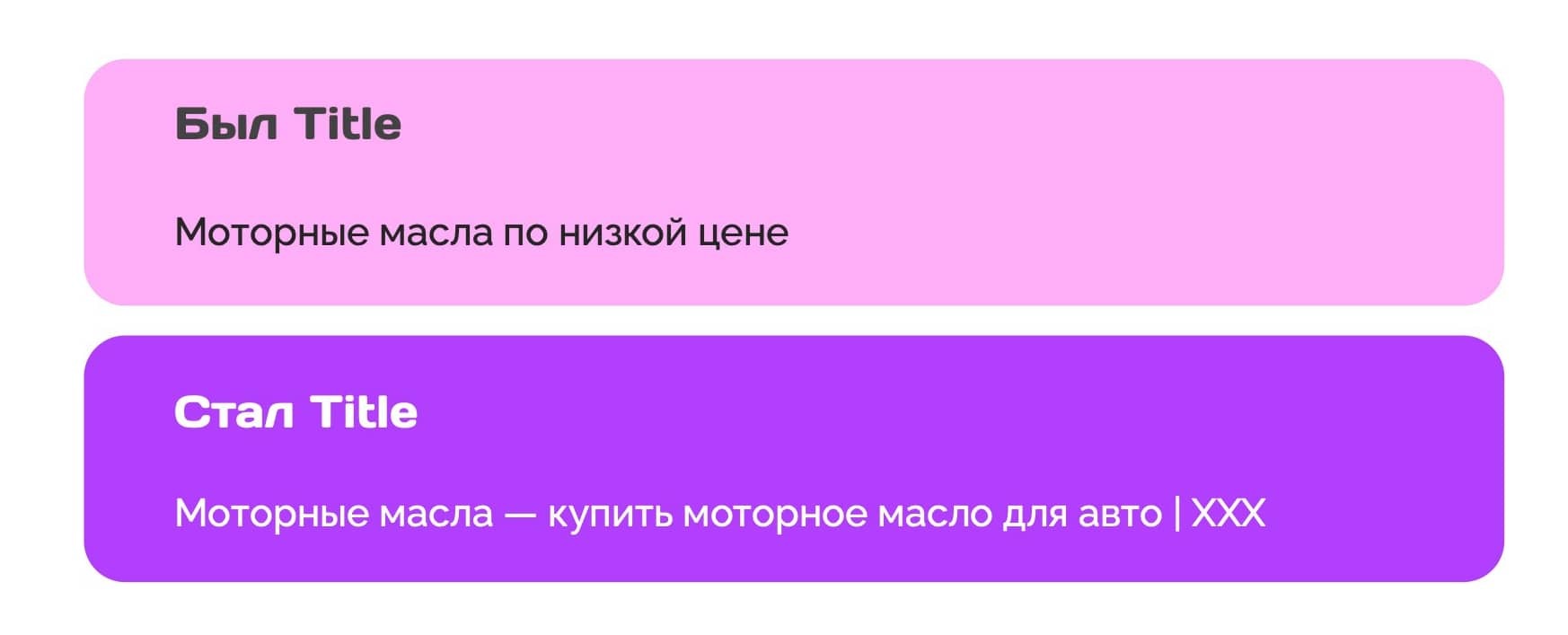

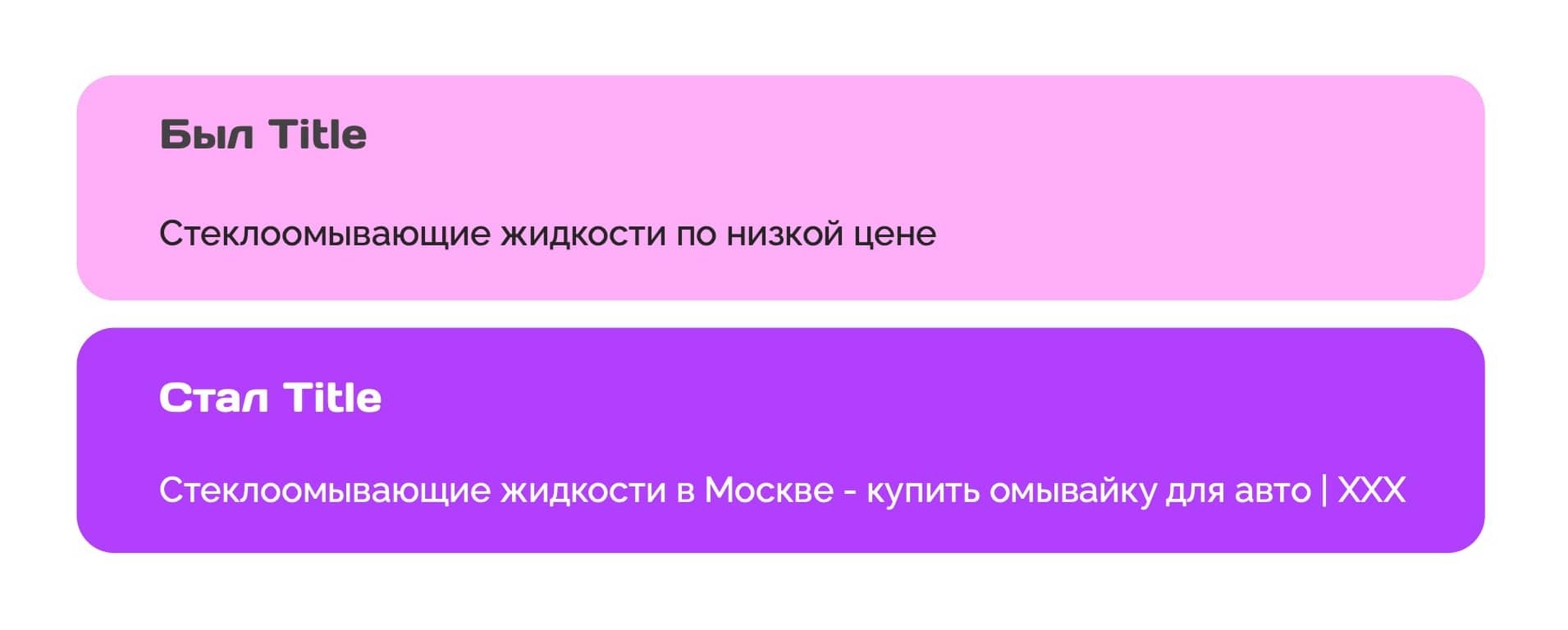

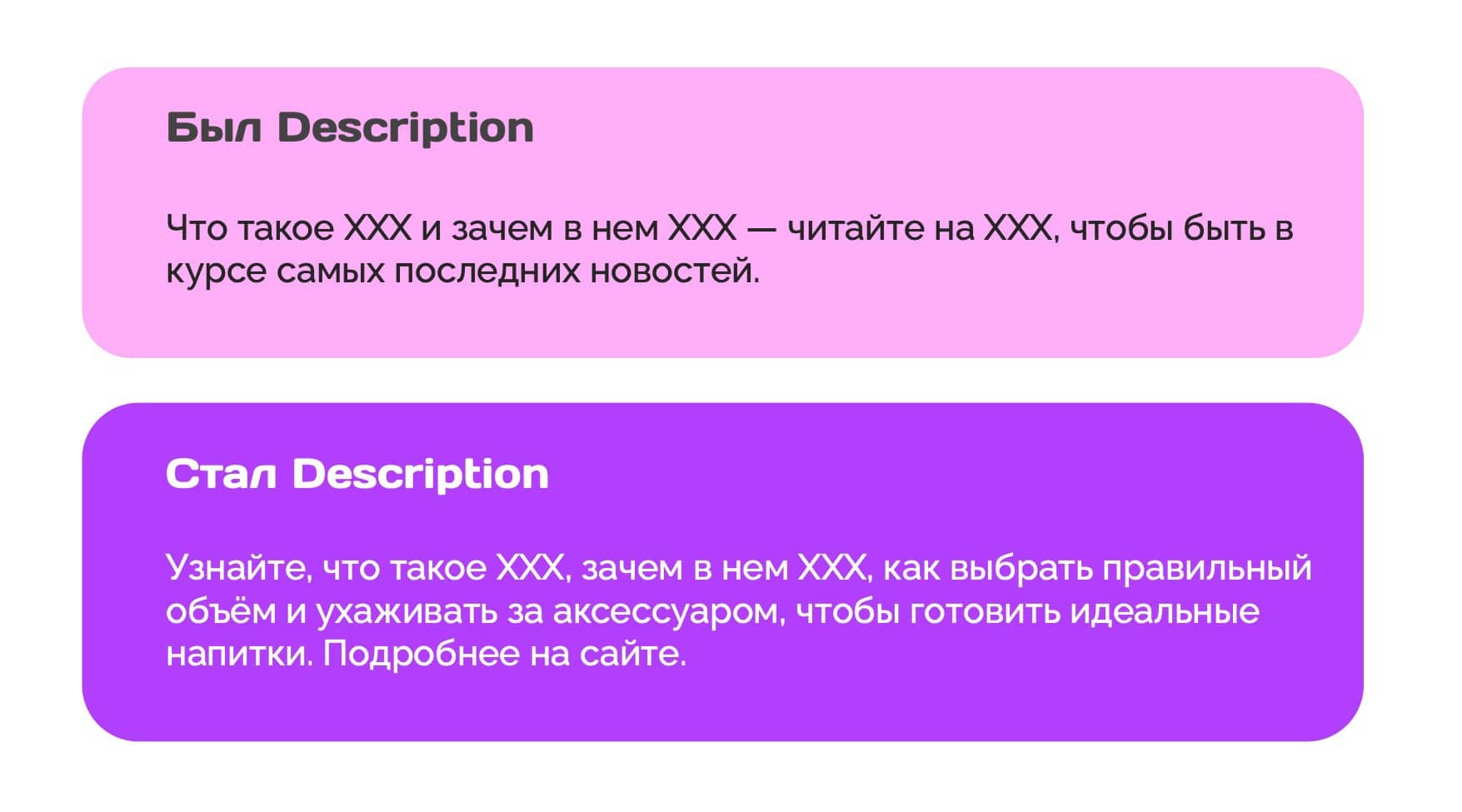

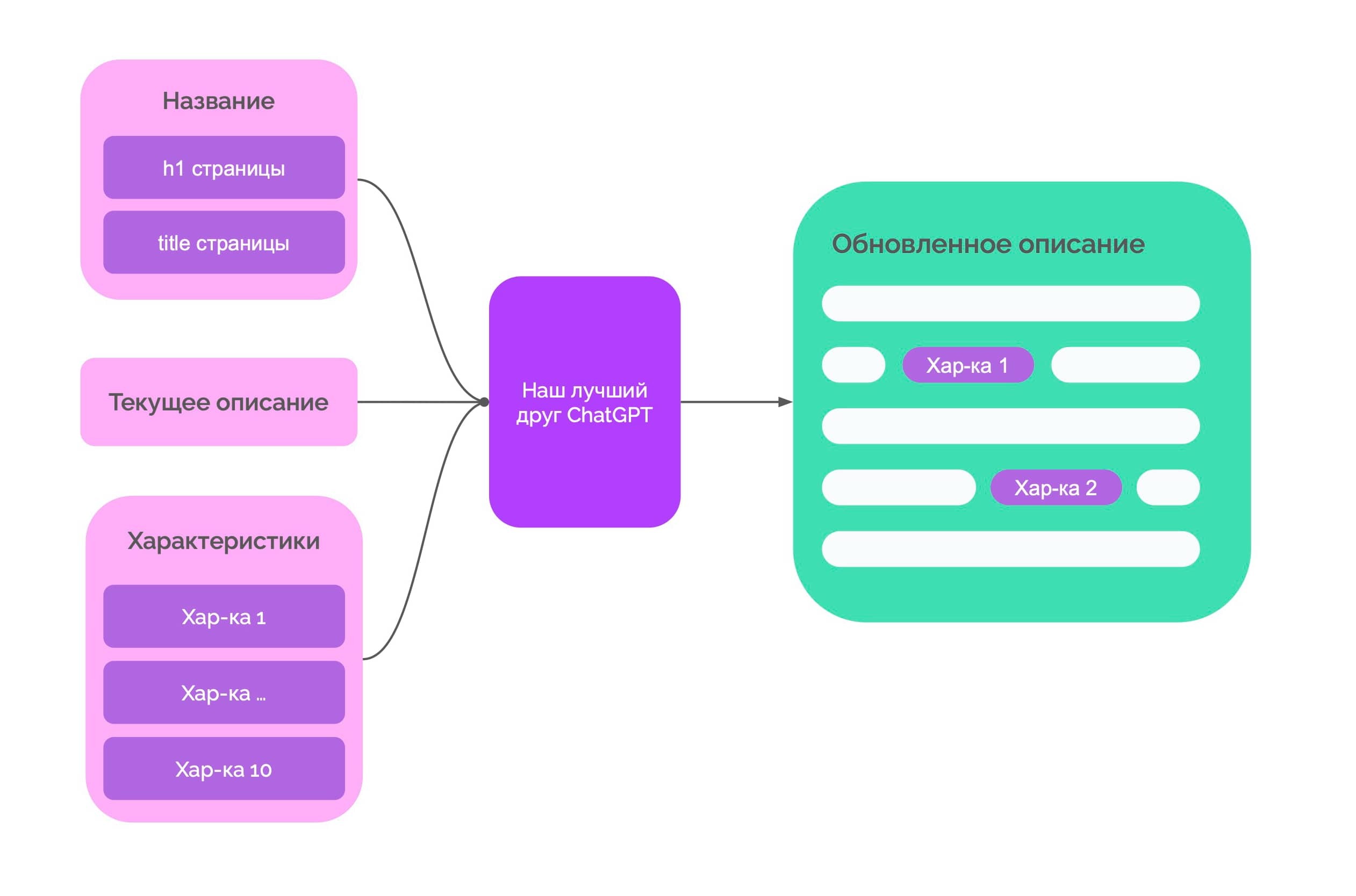

В Molinos мы используем нейросети для SEO-копирайтинга как технический инструмент. Запросы к нейросетям делаются через API — это принципиально важно. Поскольку он снимает ограничения по объему, позволяет встраивать AI в SEO-процессы и работать не с отдельными текстами, а с массивами контента.

Ниже — разбор того, какие задачи в SEO действительно имеет смысл автоматизировать, где проходит граница здравого смысла, и какие измеримые результаты это дает на практике.